Das Wichtigste in Kürze:

- Definition: Verschiedene Begriffe wie GAIO, AIO, GEO und LLMO beschreiben die Optimierung von Webseiten für Sprachmodelle und durch generative KI erweiterte Suchmaschinen, um deren Auffindbarkeit zu erhöhen. LLMO zielt darauf ab, Unternehmen dabei zu helfen, ihre Marke, Leistungen und Produkte in den Ausgaben führender Generative Engines, wie z. B. ChatGPT, Google Gemini und AI Overviews (früher Google SGE), prominent zu platzieren.

- Wichtigkeit von Retrieval Augmented Generation (RAG): RAG ist ein Framework zur Verbesserung der Qualität von LLM-erzeugten Antworten. Das Modell wird dabei auf externen Wissensquellen basiert, um die interne Darstellung von Informationen des LLM zu ergänzen. So muss ein Sprachmodell auch nicht laufend neu trainiert werden.

- Optimierung für externe Wissensquellen: Es ist effektiver, die Auffindbarkeit deiner Inhalte in externen Wissensquellen zu verbessern, die von Sprachmodellen als Referenz genutzt werden, anstatt zu versuchen, die Trainingsdaten der Modelle direkt zu beeinflussen.

- Adaption von SEO-Strategien: Für eine effektive OnPage-GAIO sollten Inhalte relevant und passend formatiert sein, um in KI-erweiterten Suchmaschinen und bei Sprachmodellen als zuverlässige Antworten hervorzustechen. Im Kontext OffPage-GAIO ist die Teilnahme an Datenbank- und Aggregator-Websites sowie effektive Online-PR essenziell.

Generative Erfahrungen kommen – ganz egal, ob deine digitale Marke bereit dafür ist:

- Google SGE bzw. AI Overviews wurden nach der Google I/O am 14. Mai 2024 in den USA ausgerollt.

- AI Overviews werden seit dem 26. März 2025 in Deutschland, Österreich und der Schweiz vor allem bei informativen und lokalen Suchanfragen angezeigt.

- Mehr und mehr Chatbots neben ChatGPT, wie z. B. Google Gemini und Anthropics Claude, sprießen aus dem Boden.

- ChatGPT stellt seit 29. März 2024 Links prominenter dar.

Es ist also höchste Zeit, dass du dich aktiv mit der Optimierung für Sprachmodelle und Chatbots beschäftigst. In diesem Ratgeber lernst du:

- warum die Optimierung für Sprachmodelle häufig missverstanden wird

- wieso SEO nicht stirbt, sondern sogar noch wichtiger geworden ist

- warum Retrieval Augmented Generation die Zukunft ist

- und welche konkreten Schritte du umsetzen musst, um mehr Traffic über Chatbots zu bekommen.

Bereit?

-

Zuletzt aktualisiert: 12. Mai 2025Google SGE (Search Generative Experience), AI Overviews & SEO

Zuletzt aktualisiert: 12. Mai 2025Google SGE (Search Generative Experience), AI Overviews & SEO -

Zuletzt aktualisiert: 28. Mai 2025Google AI Overviews: Was sich 2025 für SEO & SEA ändert

Zuletzt aktualisiert: 28. Mai 2025Google AI Overviews: Was sich 2025 für SEO & SEA ändert -

Zuletzt aktualisiert: 12. Mai 2025Ist SEO tot? Die Zukunft von SEO in einer KI-Welt

Zuletzt aktualisiert: 12. Mai 2025Ist SEO tot? Die Zukunft von SEO in einer KI-Welt -

Zuletzt aktualisiert: 25. Juni 2025Google AI Mode / Search verstehen: Überblick & Features

Zuletzt aktualisiert: 25. Juni 2025Google AI Mode / Search verstehen: Überblick & Features -

Zuletzt aktualisiert: 22. Mai 2025ChatGPT Search (SearchGPT) Optimierung: Die Anleitung

Zuletzt aktualisiert: 22. Mai 2025ChatGPT Search (SearchGPT) Optimierung: Die Anleitung

Was ist LLMO?

Typische Definition aus dem Internet

LLMO steht für Large Language Model Optimization (Optimierung für Sprachmodelle). Der Begriff beschreibt eine Reihe von Maßnahmen, um die Antworten von Chatbots, wie z. B. ChatGPT, Google Gemini und Claude, oder LLM-basierten generativen Erfahrungssystemen, wie Google SGE und Perplexity AI, zu beeinflussen.

Eines solltest du zu dieser Definition wissen:

Es gibt aktuell noch keinen einheitlichen Begriff für diese Praxis. Gängig sind derzeit:

- Large Language Model Optimization (LLMO),

- Generative Artificial Intelligence Optimization (GAIO)

- Artificial Intelligence Optimization (AIO)

- Answer Engine Optimization (AEO)

- und Generative Engine Optimization (GEO).

Jeder dieser Begriffe beschreibt unterschiedliche Ansätze und Umfänge.

Unsere Definition

GAIO zielt darauf ab, Unternehmen dabei zu helfen, ihre Marke, Leistungen und Produkte in den Ausgaben führender Generative Engines, wie z. B. ChatGPT, Google Gemini und Google AI Overviews, prominent zu platzieren.

Warum ist die Definition schwierig?

Die Trainingsdaten eines Sprachmodells sind zwar beeinflussbar, aber dies müsste im großen Stil erfolgen, um einen Effekt zu sehen. Das wird für Unternehmen aus meiner Sicht kaum möglich und nicht lukrativ sein. Aus diesem Grund lasse ich diesen Aspekt bewusst weg.

Der Optimierungshebel liegt aus meiner bisherigen Erfahrung in Retrieval Augmented Generation …

Retrieval Augmented Generation (RAG)?

Große Sprachmodelle treffen bei manchen Fragen den Nagel auf den Kopf, ein anderes Mal geben sie zufällige Informationen aus ihren Trainingsdaten wieder. Wenn sie gelegentlich so klingen, als hätten sie keine Ahnung, was sie sagen, dann liegt das daran, dass sie tatsächlich keine haben.

LLMs wissen, wie Wörter statistisch zusammenhängen, aber nicht, was sie bedeuten.

Was ist Retrieval Augmented Generation (RAG)?

RAG ist ein Framework zur Verbesserung der Qualität von LLM-erzeugten Antworten: Das Modell wird auf externen Wissensquellen basiert, um die interne Darstellung von Informationen des LLM zu ergänzen.

Die Implementierung von RAG in einem auf LLM basierenden Frage-Antwort-System hat zwei Hauptvorteile:

- Das Modell hat Zugang zu aktuellen, zuverlässigen Fakten.

- Benutzer*innen können auf die Quellen des Modells zugreifen. So können dessen Aussagen auf Genauigkeit überprüft werden – und sind somit vertrauenswürdiger.

RAG reduziert auch die Notwendigkeit, das Modell kontinuierlich mit neuen Daten zu trainieren und seine Parameter zu aktualisieren, wenn sich etwas ändert.

RAG praxisnah erklärt

In der Ausgabe eines statischen LLM zu erscheinen, könnte wertvoll für die Sichtbarkeit deiner Marke sein, wird jedoch keinen Traffic auf deine Website lenken.

Plattformen, wie ChatGPT-4, die mit dem Internet verbunden sind, verbessern die Ausgabe von LLMs, indem sie aktuelle, relevante Inhalte aus Suchmaschinenindizes abrufen (externe Wissensquelle). Dieser Prozess wird als RAG bezeichnet.

Es ist die Kombination der Leistung des LLM mit einer Auswahl von hochrelevanten Inhalten aus dem Internet, die es dem Chatbot ermöglicht, eine aktuellere und faktisch genauere Ausgabe zu produzieren.

Was du jetzt verstehen solltest:

Sprachmodelle und darauf basierende Chatbots brauchen aufgrund ihrer Funktionsweise immer eine Suchfunktion, um aktuelle und korrekte Antworten zu liefern. Deswegen nutzt auch ChatGPT die Bing-Suche. SEO wird also nicht weniger relevant, sondern gewinnt eine neue Sparte.

Ein Beispiel für RAG

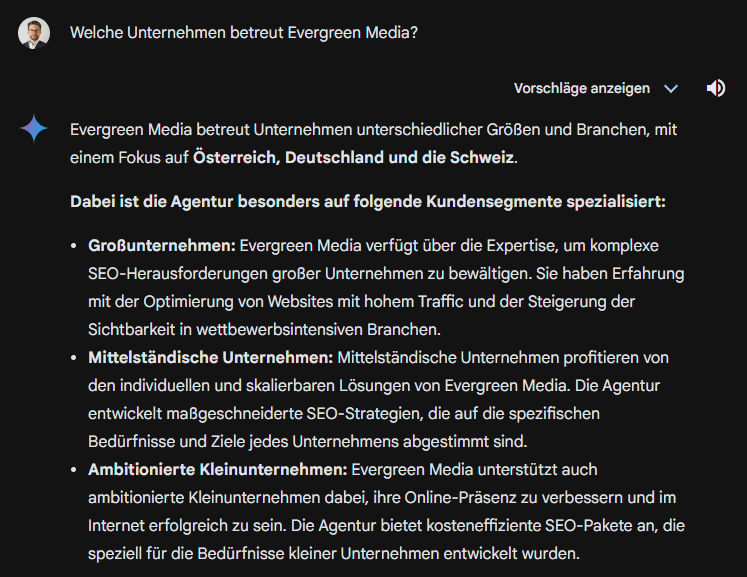

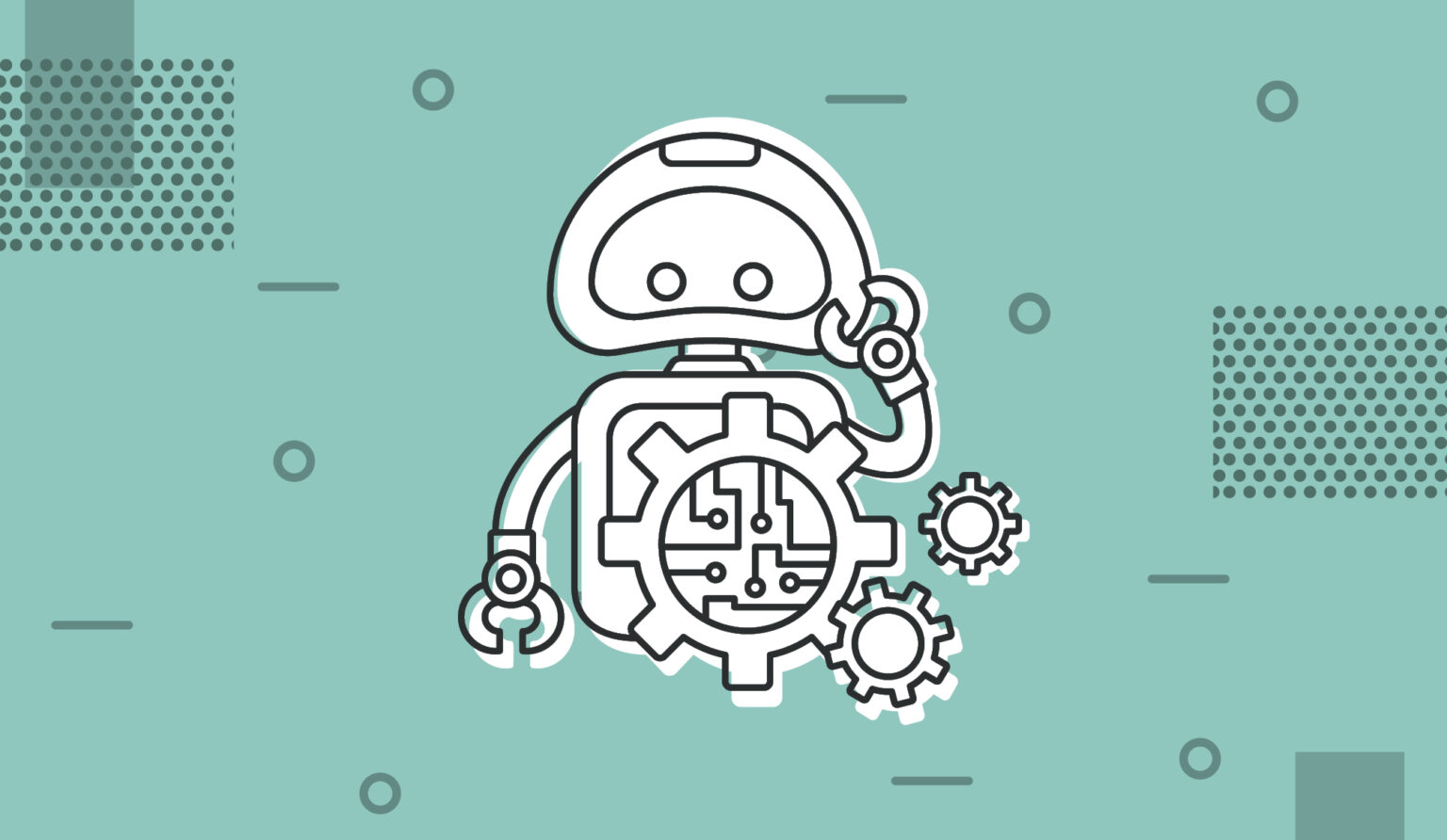

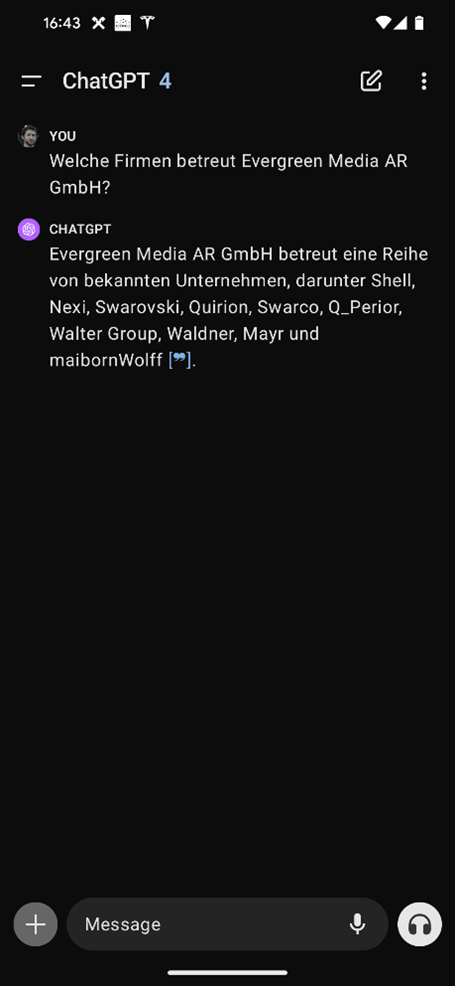

Wie Retrieval Augmented Generation in der Praxis aussehen kann, zeigen dir die folgenden Screenshots:

Diese Informationen sind nicht Teil der Trainingsdaten von GPT-4. ChatGPT hat diese Informationen stattdessen über Bing gesucht und dann über das Sprachmodell ausformuliert.

Und noch ein Beispiel von Google Gemini:

Diese Antwort konnte ich beeinflussen durch ein paar strukturierte Informationen im Footer (keine strukturierten Daten).

Wie zu Beginn erwähnt, stellt ChatGPT seit Kurzem Links noch klarer dar, was das Traffic-Potenzial erhöht.

Kann für Sprachmodelle mit RAG optimiert werden?

Die Optimierung für RAG-LLMs ähnelt der Optimierung für Featured Snippets, allerdings mit mehr Variablen und weniger Vorhersehbarkeit. Der Erfolg hängt davon ab, das Format und die Relevanz des bestehenden, leistungsstarken Inhalts zu (über)treffen.

✓ über 24.000 Abonnenten ✓ min. ein neues Video pro Woche ✓ geballtes Praxiswissen

Grundsätze der Optimierung für Sprachmodelle

1. Es ist zwar theoretisch möglich, die Trainingsdaten von LLMs zu beeinflussen, aber das müsste in einem extrem großen Stil passieren.

Zum einen wird dies für Unternehmen kaum möglich sein, zum anderen sind die Ergebnisse nicht kontrollierbar. Mehr dazu lernst du in diesem Artikel von Olaf Kopp.

2. Sprachmodelle werden nicht laufend komplett neu trainiert, sondern nutzen RAG, um aktuelle Informationen liefern zu können.

Der Hebel für Unternehmen ist nicht die Manipulation der Trainingsdaten eines LLMs, sondern die Verbesserung der Auffindbarkeit in der jeweiligen externen Wissensquelle.

3. Bei der Optimierung für Sprachmodelle und Chatbots geht es um Antworten statt URLs.

Bei SEO splitten wir Seiten nach Suchintention und Keywords auf – bei GAIO dreht sich alles um Antworten.

Es kann sein, dass Themenseiten wieder an Bedeutung gewinnen. Immerhin ist der kleinstmögliche Teil bei Chatbots und KI-erweiterten Suchmaschinen nicht die URL, sondern die Antwort.

4. Wir optimieren unsere Auffindbarkeit in den jeweiligen externen Wissensquellen für RAG.

Konkret bedeutet das:

- Für ChatGPT optimieren wir auf die Bing-Suche.

- Für Gemini und AI Overviews optimieren wir auf die Google-Suche.

Wer eine hohe Auffindbarkeit in Suchmaschinen genießt, wird diese Sichtbarkeit in Chatbots übertragen.

5. Nutzereingaben bei Chatbots sind komplexer und haben mehr Nuancen, wodurch Keyword-Recherchen und Antwortabdeckung sich ändern müssen.

Klassische Keywords werden meiner Meinung nach nur Säulen darstellen, zu denen wir passende Fragen und Antworten liefern.

Die richtigen Fragen finden wir u. a. über:

- „Nutzer fragen auch“ oder People Also Ask (PAA)

- Follow-up-Fragen aus Konversationen mit Google, Bing, ChatGPT und Perplexity

- Kundenbefragungen

- Vertrieb

In dieser Folge lernst du mehr über Keyword-Recherche in Zeiten von generativen Engines:

OffPage-GAIO

Konkret geht es abseits der eigenen Website um:

- Datenbank-Websites: z. B. Crunchbase, sortlist oder FirmenABC

- Wissensaggregatoren: große, moderierte UGC-Websites wie z. B. Reddit, LinkedIn, YouTube und Wikipedia

- große Publisher wie z. B. The Verge, Financial Times oder Forbes

Unser Ziel:

- Wir gewinnen Sichtbarkeit, weil unsere Erwähnung auf diesen Plattformen durch RAG direkt aufgegriffen wird. Ein Beispiel: Wir landen in einer Aufzählung der besten GAIO-Agenturen Deutschlands.

- Wir schaffen es über diese Plattformen in die Trainingsdaten der LLMs.

Was musst du beachten?

Die jeweilige externe Website/Plattform darf den betreffenden Bot nicht geblockt haben, wenn wir sie für die Optimierung nutzen wollen.

Hier findest du eine Liste von großen Websites und welche Bots sie geblockt haben. Und hier noch eine Liste mit Domains, denen Google vertraut.

| Was ist das? | Datenbank-Websites sind klassische Aggregatoren mit irgendwelchen Listings, z. B. Firmenverzeichnisse, Bewertungsplattformen etc. |

| Beispiele | sortlist.de |

| Was tun? | – Ein vollständiges Profil zu deiner Marke anlegen. – Möglichst im Ranking der Plattform aufsteigen: z. B. weit oben auf der Seite „Beste SEO-Agenturen in Innsbruck“ aufscheinen. |

| Was ist das? | Auf diesen Plattformen kannst du Content publizieren, der moderiert wird. |

| Beispiele | youtube.com wikipedia.org |

| Was tun? | – Aktiv als Marke auf den Plattformen teilnehmen. – Das Spiel der jeweiligen Plattform gut spielen: z. B. einen beliebten YouTube-Kanal aufbauen. |

| Was ist das? | Zeitungen, Magazine etc. |

| Beispiele | theverge.com forbes.com |

| Was tun? | – Sponsored Content publizieren lassen, um dir deinen Platz zu erkaufen. – Mit Online-PR-Kampagnen Journalisten überzeugen, über deine Marke zu berichten. |

Deswegen poche ich gerade auch so auf das Thema digitale PR. Linkbuilding ist schön und gut, aber minderwertige Artikel aus Private Blog Networks helfen dir hier nicht.

Wenn du bei KI-erweiterten Suchmaschinen und Sprachmodellen Sichtbarkeit generieren willst, musst du immer und immer wieder bei großen Publishern erwähnt werden. Ich sage explizit erwähnt, denn es geht nicht um Backlinks.

Es geht um Prominenz für direkte Abfragen (ChatGPT über Browsing, also RAG) und ausreichend Erwähnungen, um evtl. in den Trainingsdaten hervorzustechen.

Mit Digital PR steigern wir deine Sichtbarkeit bei Chatbots wie ChatGPT und Google Gemini.

OnPage-GAIO

Manche werden dir jetzt empfehlen, auf einzelne Antworten zu optimieren. Ich bezweifle, dass dies langfristig der sinnvollste Weg ist.

Nehmen wir den Fall AI Overviews.

iPullRank schreibt über seine Experimente:

The more saturated the topic or vague the query, the more volatility we’ll see in the results day to day.

Garret Sussman, iPullRank, 6. Februar 2024

Das klingt weder nach einer nachhaltigen Strategie noch nach einer guten Zeitinvestition. Wir wollen alle unsere Inhalte nach GAIO-Best-Practices optimieren und so die Wahrscheinlichkeit erhöhen, in Chatbots aufzuscheinen.

Sinnlose Kleinstarbeit bleibt sinnlos.

Dein Framework

- Es geht immer um Relevanz und Format. Fließtext-Gelaber ist der Feind.

- Wir bauen um unsere klassischen Keywords herum Fragen und Antworten auf.

- Anstatt User*innen einen 4.000-Wörter-Artikel über die Kalorien von Äpfeln zu liefern, geben wir ihnen die Antwort schnell und einfach.

Sprache

- Verwende einfache, klare und informationshaltige Sprache (denk daran, was in Featured Snippets funktioniert).

- Erkläre Fachbegriffe in strukturierter Form, kurz und knackig.

Struktur

- Wir wollen Ranch-Style-Content statt Skyscraper-Content.

- Starte Long-Form-Content mit einer Kurzzusammenfassung der wichtigsten Punkte bzw. Key Takeaways.

- Starte jedes Kapitel mit einer Kurzantwort.

- Achte darauf, Inhalte so aufzubereiten, dass sie sich für Antworten eignen (dabei kommt es auf das Sprachmodell an):

– Länge

– Formatierung

– Informationsdichte - Nutze bekannte Modelle wie Vor- und Nachteile, Vergleiche etc., um gute Antworten zu liefern.

- Orientiere dich bei der Strukturierung deiner Website daran, wie das LLM dein Thema strukturiert.

- Nutze strukturierte Daten.

Inhalt

- Sieh dir an, was aktuell als Antwort ausgeliefert wird, und lerne daraus hinsichtlich Format und Relevanz.

- Stelle einzigartige Informationen oder Daten bereit, die nicht in den bisherigen Trainingsdaten oder auf anderen Webseiten zu finden sind (Information Gain).

- Füge Zitate hinzu (z. B. von bekannten Expert*innen oder einer Einrichtung).

- Ergänze deine Inhalte mit Statistiken und quantitativen Daten.

- Füge Quellenangaben von autoritativen Quellen hinzu.

Aufbereitung

- Sammle User Generated Content (UGC) und stelle die Einblicke in einer zitierbaren Form dar, also als hilfreiche Antwort.

Kommentieren